秒建工作环境

Matrix Fusion在云端预安装主流深度学习框架、数据科学资料库和GPU驱动,用户无需耗费时间搭建开发环境,可在一分钟内通过简单的鼠标点击完成开发环境设置,可以迅速灵活调用CPU和GPU资源。

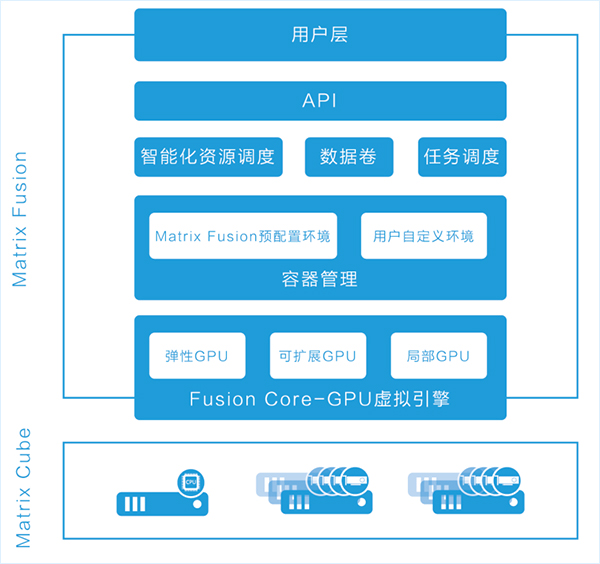

智能化资源调度

Matrix Fusion 支持各类硬件及操作系统,提供端到端的基础设施软件解决方案,管理基础CPU和GPU计算资源,能够自动进行工作负载资源调配。深度学习是同时利用CPU和GPU处理工作负载的典型应用,Matrix Fusion通过整合用户所有的硬件资源(集群亦或是单机)成为CPU+GPU资源池,再将资源根据开发者需要重新分配CPU和GPU到开发者的虚拟环境下,管理员也可以将多余的计算资源灵活分配给其他用户或更为严苛的工作负载。

用户在不同的虚拟环境中可以选择在CPU资源上开发,然后在GPU资源中测试,需要扩展训练到更多GPU上时,可立即调用虚拟环境中任意数量的GPU资源。

容器管理

Matrix Fusion 构建于强大的计算硬件和GPU虚拟化的基础上,搭载了全方位的容器管理方案。核心负载引擎容器化,是作为极大简化深度学习和AI工作流程的最新技术,在金钱、人力、时间上投资不菲。而Matrix Fusion无需进行个性化调整,用户只需登录操作界面,就可以直接调用专业化容器解决方案。 Matrix Fusion容器管理层包括1个内置资源库,可以管理预配置容器(包括了每一种部署场景或个性化生成容器): 预配置环境:Matrix Fusion预配置最新的深度学习框架和数据科学数据库,用户可以直接使用TensorFlow、Caffe、Torch以及其他社区的最新技术版本。 DIY开发环境:用户可以利用“工作区快照”或“调入容器”来修改并保存容器环境,DIY一个更贴合自己使用习惯的开发环境。Matrix Fusion “调入容器”可以为用户提供一个简约的容器(仅含操作系统、最低配置的数据库和驱动要求),用户自行修改环境,然后上载作为标准环境进行后续开发。 用户可以通过“工作区快照”利用“Docker保存”工作流程来复制环境,修改后保存到资源库中,以便于下一次的开发工作。 容器导出:容器可导出,作为推理或其他生产部署要求用。

Fusion Core

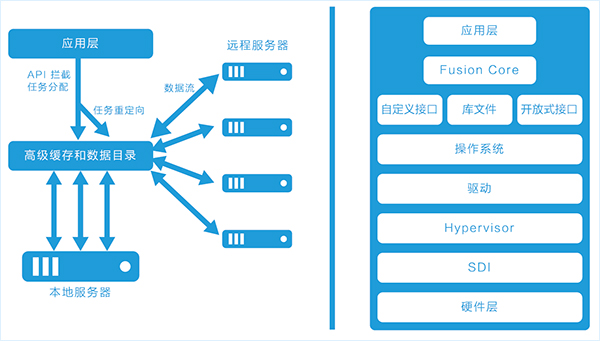

Matrix Fusion强大的灵活性来源于Fusion Core计算虚拟化引擎。Fusion Core控制应用和基础GPU计算之间的API调用指示,允许GPU负载灵活分布于本地GPU内存、网络附加GPU、扩展至高达64个GPU,提供强大的整体性能。

因为Fusion Core采用的是“透明”模式而非虚拟层或其他虚拟化方式,所以不需要对基础硬件或虚拟机环境做任何改变,也不需要改变应用编程本身。这意味着AI开发者和数据科学家可以无缝利用GPU虚拟化的优势,且将成本和集成需求降至最低。

数据卷

深度学习和AI工作负载所需数据通常来源广泛,既有线上也有线下,既有外部也有内部,既有批量文件也有文件系统等等。Matrix Fusion能够简化处理工作数据,让管理员明确网络附加存储位置并映射到容器中。只要主机能够访问数据地址,容器就可以访问数据,这让AI开发者和数据科学家的工作大幅简化. 此外,系统还支持灵活、无限制的数据映射,Matrix Fusion支持每个节点的本地NFS文件系统。这一默认选项提供了工作负载的标准地址,无论运行多大的深度学习工作负载(包括运行在多服务器之间的),都可以快速获取运行任务所需的数据